DeepSeek-OCR:面向文档AI的SOTA上下文光学压缩技术

通过 DeepSeek-OCR 模型,解锁前所未有的文档理解和高速 OCR 体验。从图片转 Markdown 到复杂的表格解析,感受下一代上下文光学压缩技术。

在 A100-40G 上推理速度高达 2500 tokens/s。

from 99+ happy users

开始使用 DeepSeek-OCR

通过三个简单的步骤将模型集成到您的工作流中:

DeepSeek-OCR 是什么

DeepSeek-OCR 是一种先进的多模态大语言模型(MLLM),专注于优化视觉数据的**光学压缩**,为复杂文档的视觉-文本压缩突破界限。

- 以 LLM 为中心的视觉方法一种研究视觉编码器从 LLM 视角如何更好理解上下文的新颖方法。

- 上下文 OCR 与解析超越简单的文本识别,理解文档结构、布局和上下文含义。

- 可扩展的分辨率支持支持多种原生和动态分辨率,以处理不同尺寸的文档而不会损失保真度。

DeepSeek-OCR 的核心能力

从高保真文本提取到复杂的文档结构转换,DeepSeek-OCR 满足您所有的文档 AI 需求。

用于强大文档 AI 的提示词示例

利用 DeepSeek-OCR 的上下文理解能力和专用提示词。

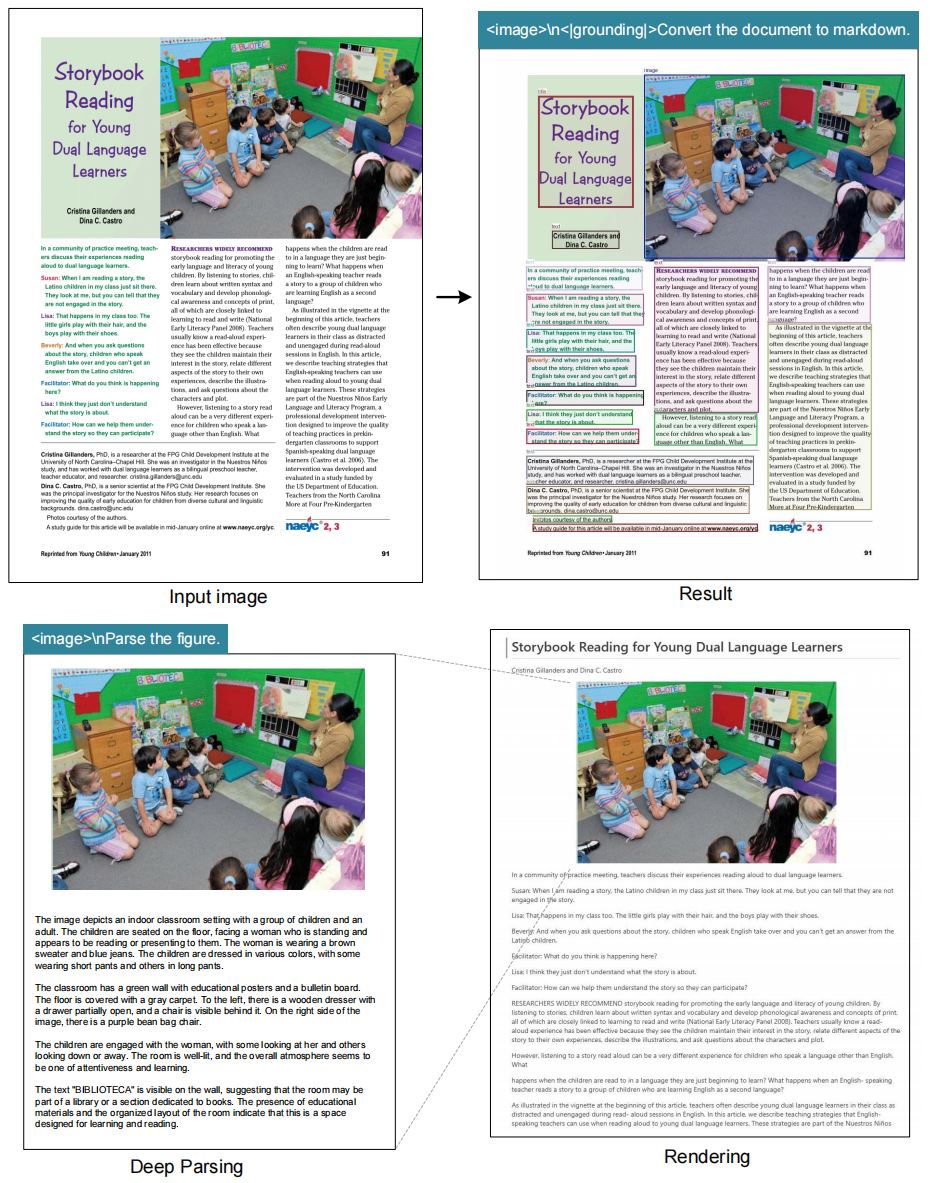

上下文文档解析

提示词:`<image>\n<|grounding|>Convert the document to markdown.` (适用于结构化提取)。

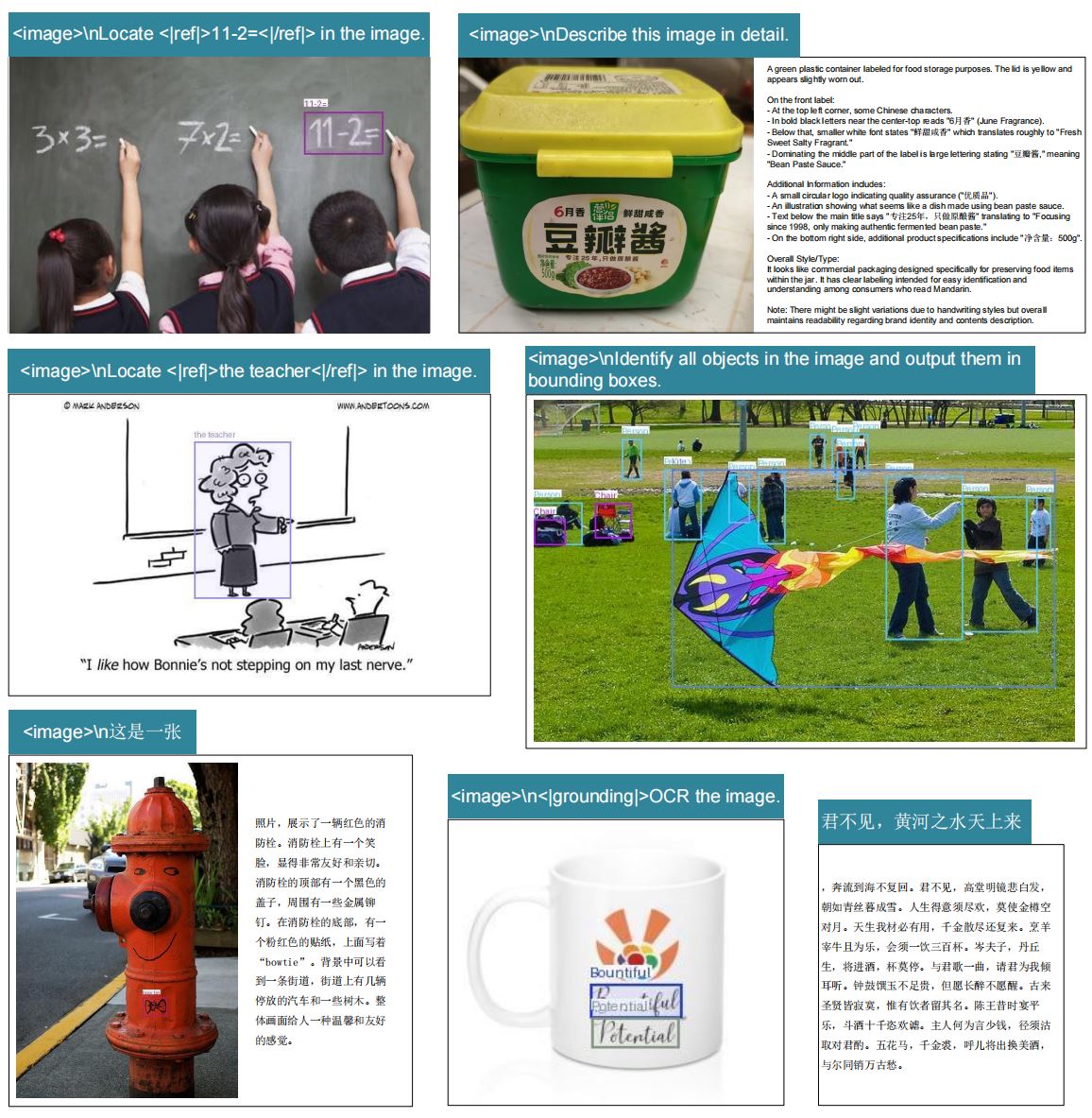

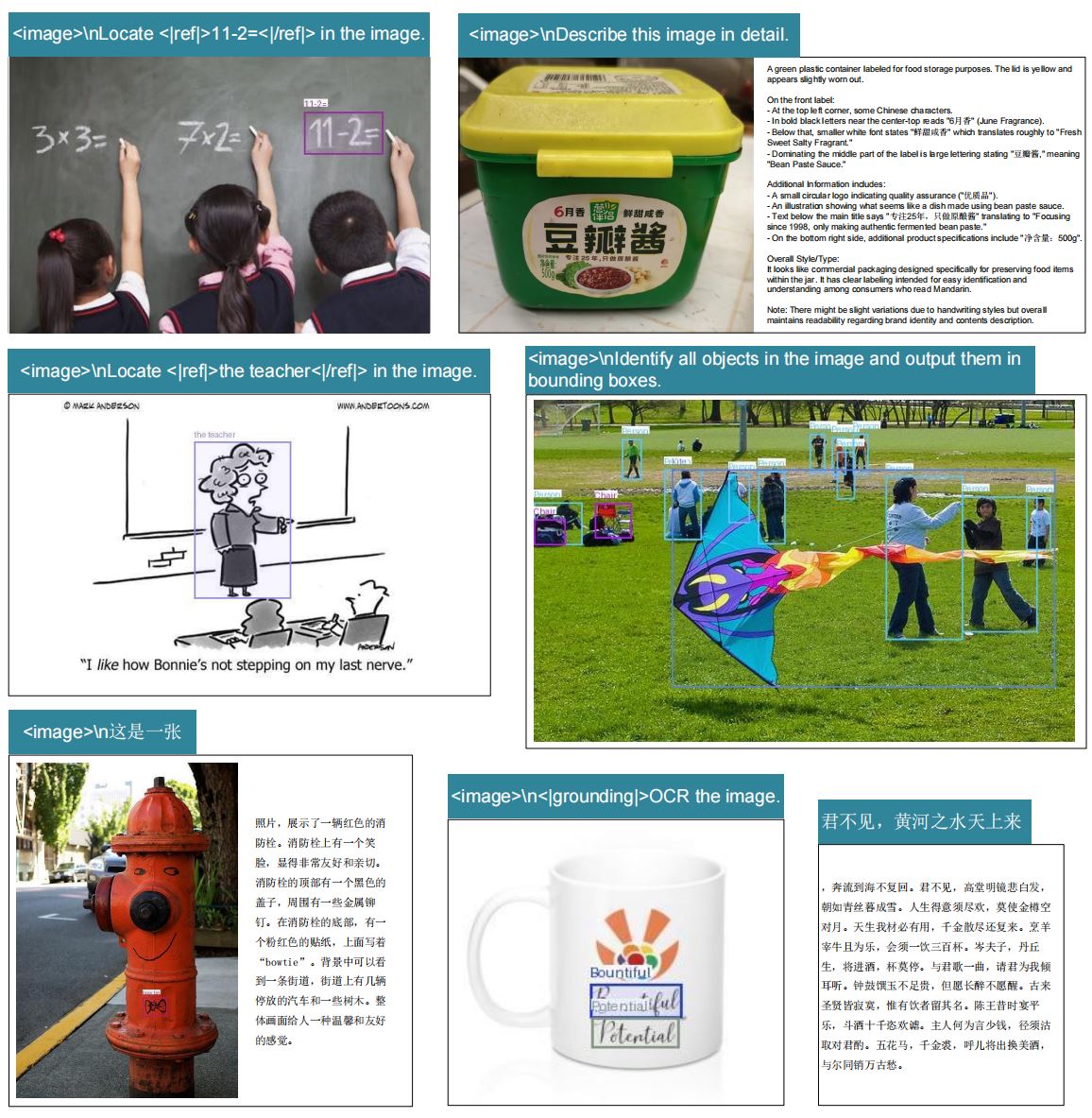

精确文本定位 (REC)

提示词:`<image>\nLocate <|ref|>xxxx<|/ref|> in the image.` (用于查找特定的文本块)。

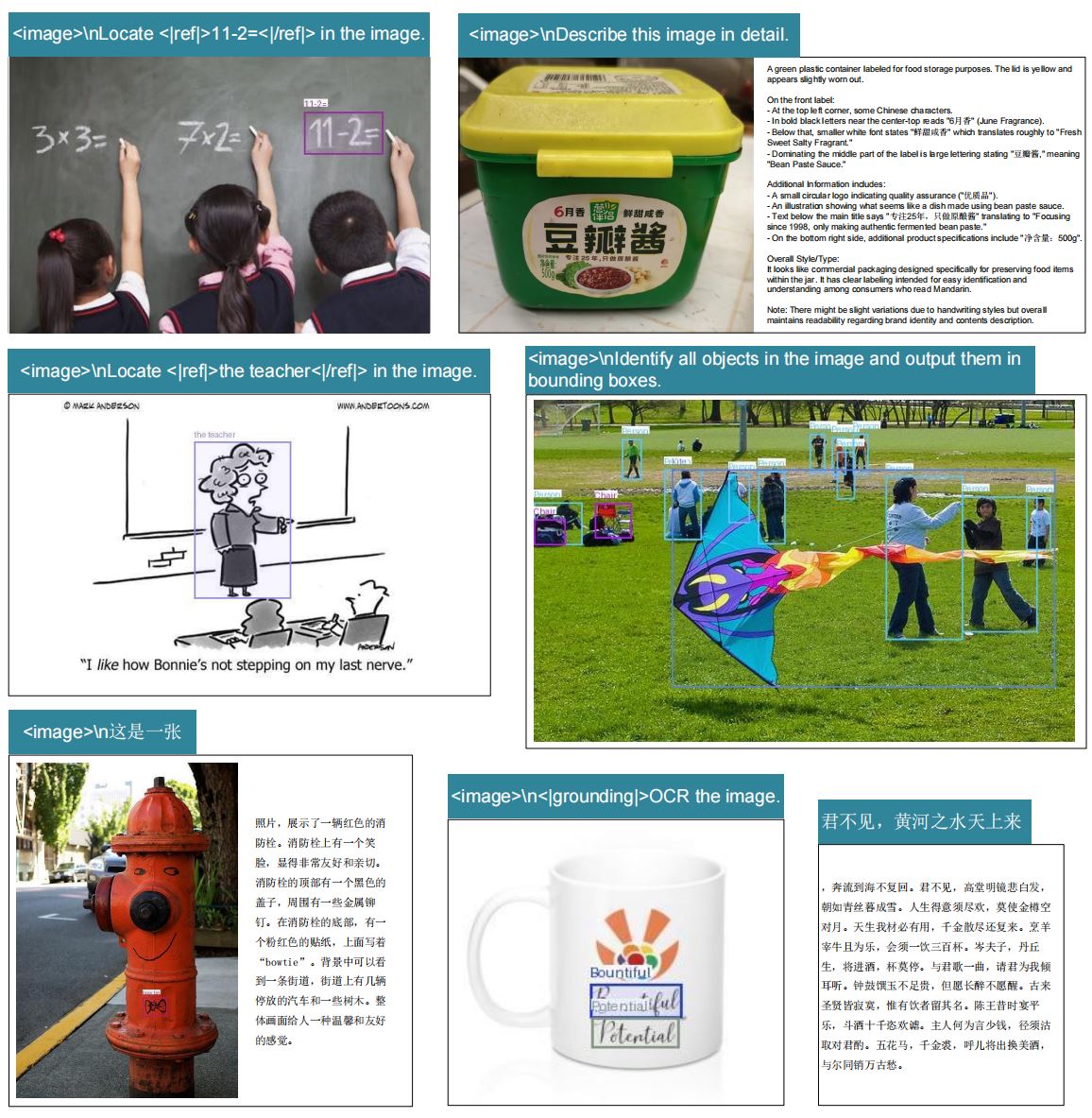

自由形式/通用 OCR

提示词:`<image>\nFree OCR.` (简单、无约束的文本提取)。

图表分析

提示词:`<image>\nParse the figure.` (用于理解文档中的视觉元素)。

详细图像描述

提示词:`<image>\nDescribe this image in detail.` (通用多模态能力)。

多语言支持

已在包括中文在内的各种复杂脚本语言上进行测试。

无与伦比的 OCR 速度和效率

DeepSeek-OCR 专为速度和高容量处理而设计。

推理速度

~2500

tokens/s (A100-40G 上的 PDF 并发处理)

分辨率模式

5+

支持的分辨率模式(包括动态模式)

GitHub Star 数

7.2k+

社区支持

关于 DeepSeek-OCR 的常见问题

如需更多技术详情,请参阅 GitHub 仓库或论文。

什么是“上下文光学压缩”?

这是 DeepSeek-OCR 的核心概念,专注于视觉编码器如何有效地将丰富的视觉上下文压缩为 LLM 的 token,以确保文档理解的最大保真度。

高速推理需要什么硬件?

vLLM 推理在 NVIDIA A100-40G 或类似的高端 GPU 上表现最佳,速度高达 2500 tokens/s,这对于大规模 PDF 处理至关重要。

DeepSeek-OCR 支持结构化数据提取吗?

支持。通过使用提示词 `<|grounding|>Convert the document to markdown.`,模型可以有效地提取文档内容并将其结构化,包括表格和列表,转换为清晰的格式。

有哪些可用的分辨率模式?

模型支持原生模式:Tiny (512×512)、Small (640×640)、Base (1024×1024)、Large (1280×1280),以及用于灵活和高保真输入的动态 Gundam 模式。

我如何贡献或报告问题?

您可以通过 fork 官方 DeepSeek-OCR GitHub 仓库、提交 Pull Request 或打开新的 Issue 来报告错误和提出建议。

我在哪里可以下载模型权重?

官方模型权重托管在 Hugging Face Hub 的 `deepseek-ai/DeepSeek-OCR` 仓库下。

立即开始使用 DeepSeek-OCR 进行构建

体验下一代文档 AI 和上下文光学压缩的性能。